动机

- 目前的多域编辑方法经常会导致面部区域出现意想不到的变化,即生成器改变了与指定属性无关的区域;

- 注意分支网络(ABN)将基于响应的视觉解释扩展到注意力机制,但是基于响应的视觉解释方法只能提取图像中已经存在的属性的注意力特征图。

贡献

- 基于互补注意特征(CAFE)的概念(同时考虑目标属性和“互补属性”来识别需要转换的面部区域,“互补属性”定义为输入面部图像中缺失的那些属性),本文提出了一种新的面部属性编辑方法,旨在仅编辑与目标属性相关的面部部分;

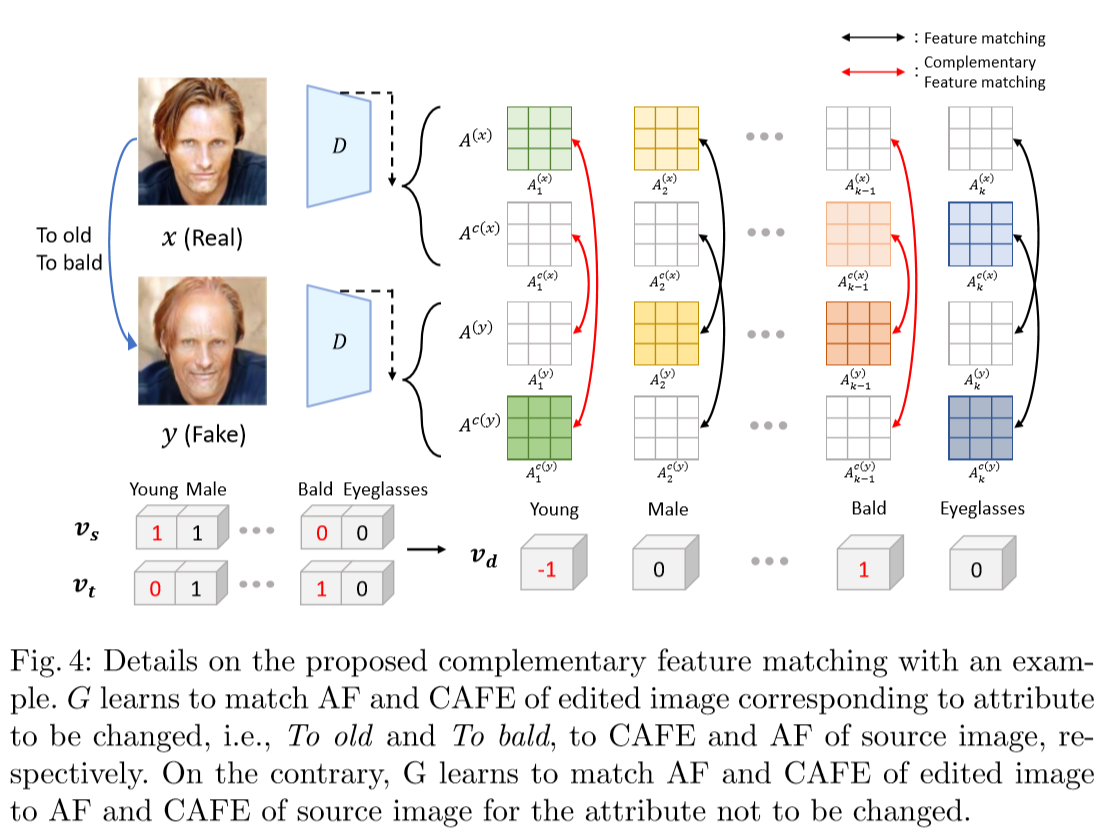

- 引入了一个互补的特征匹配损失设计来帮助训练生成器合成图像与给定的属性呈现准确和在适当的面部区域。

本文的方法

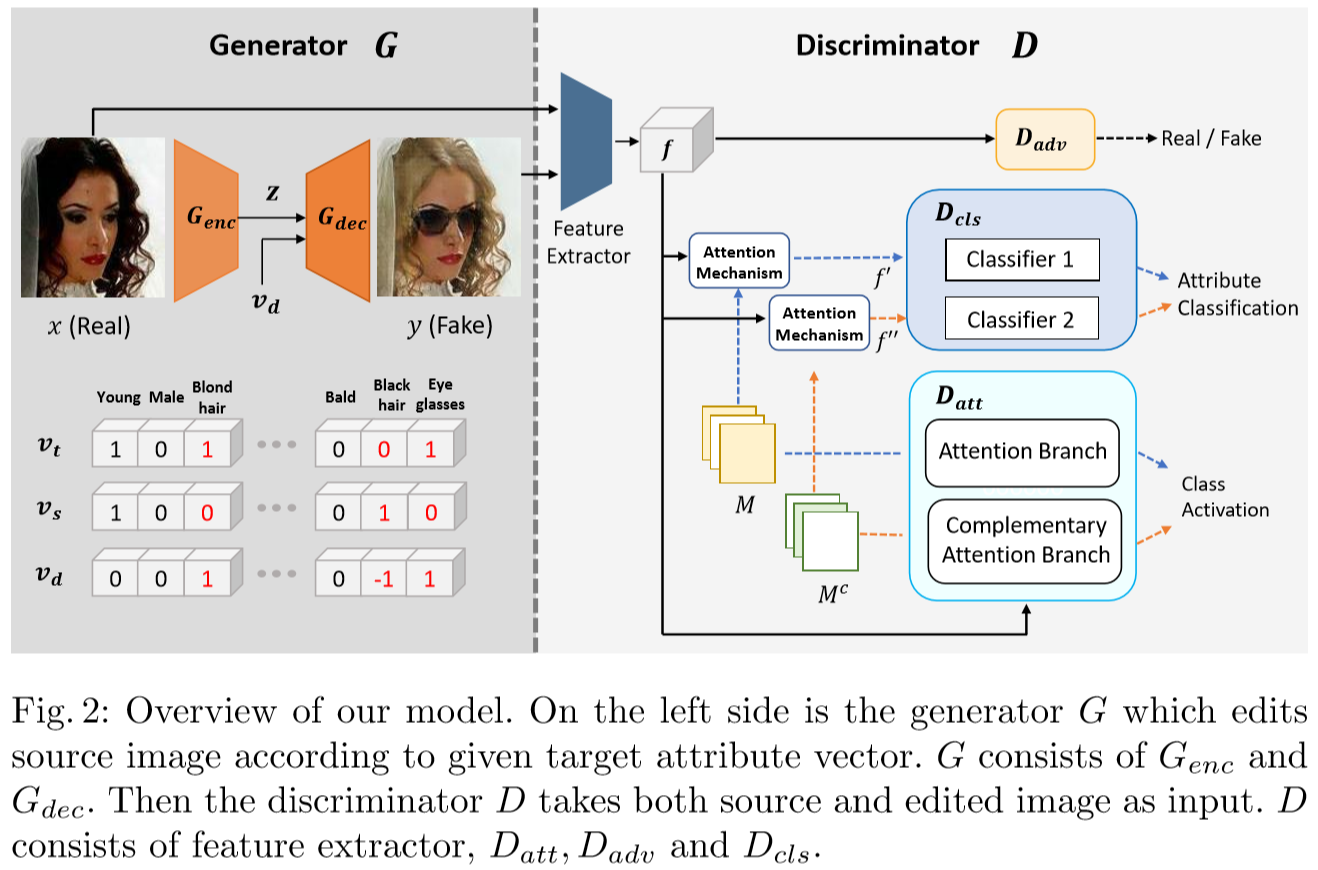

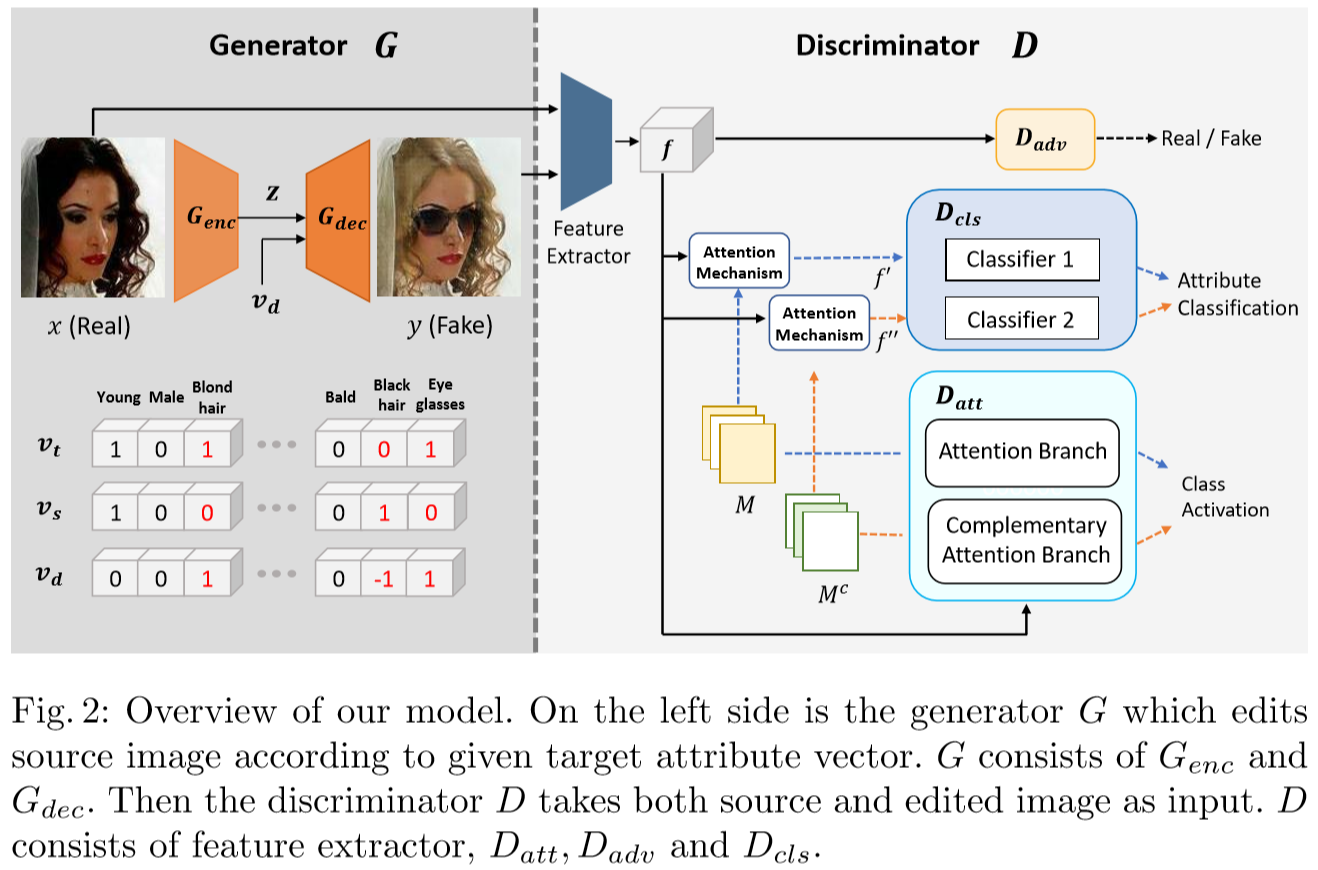

判别器

判别器由三个主要部分组成,即、和

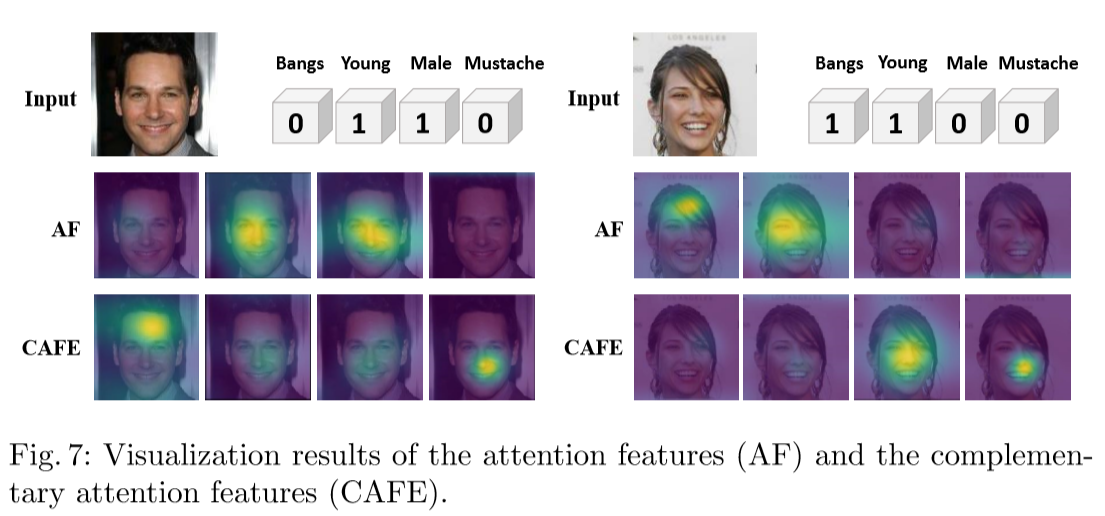

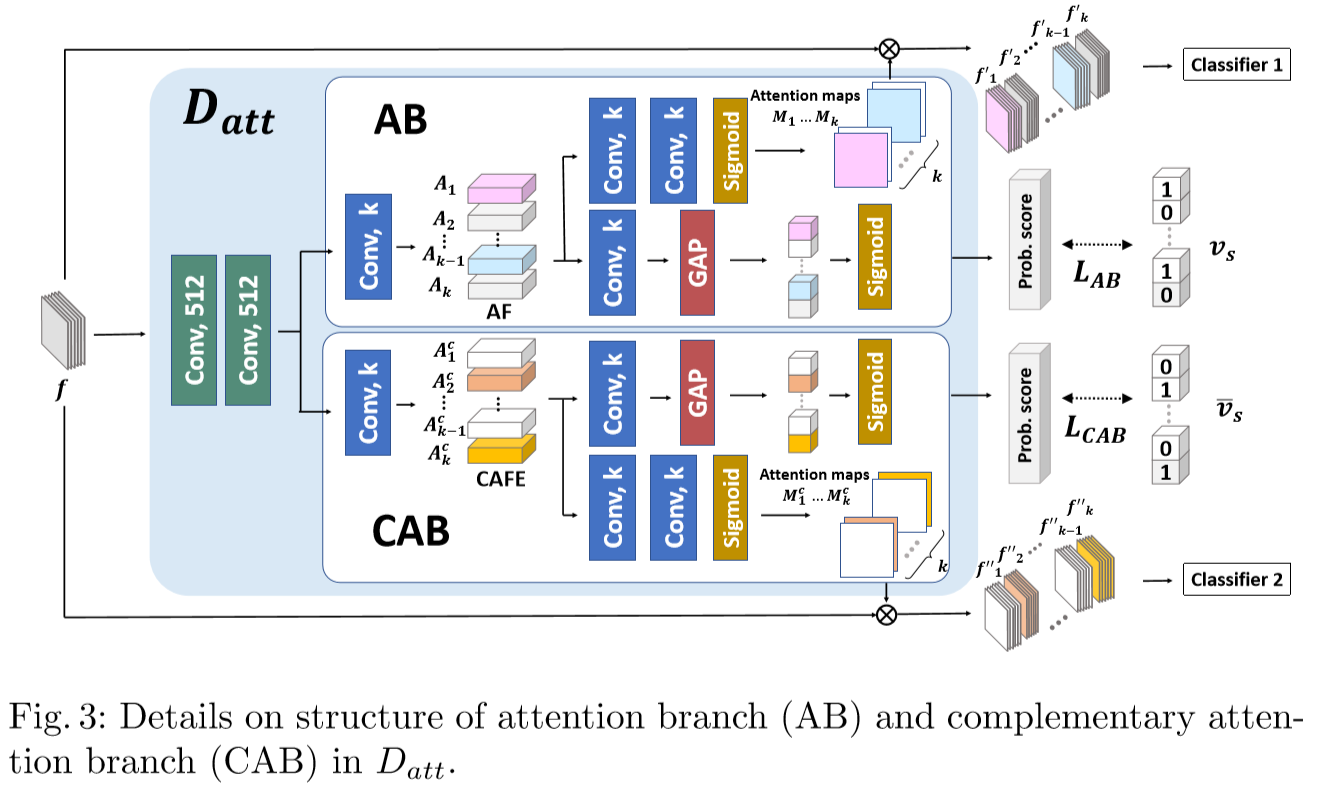

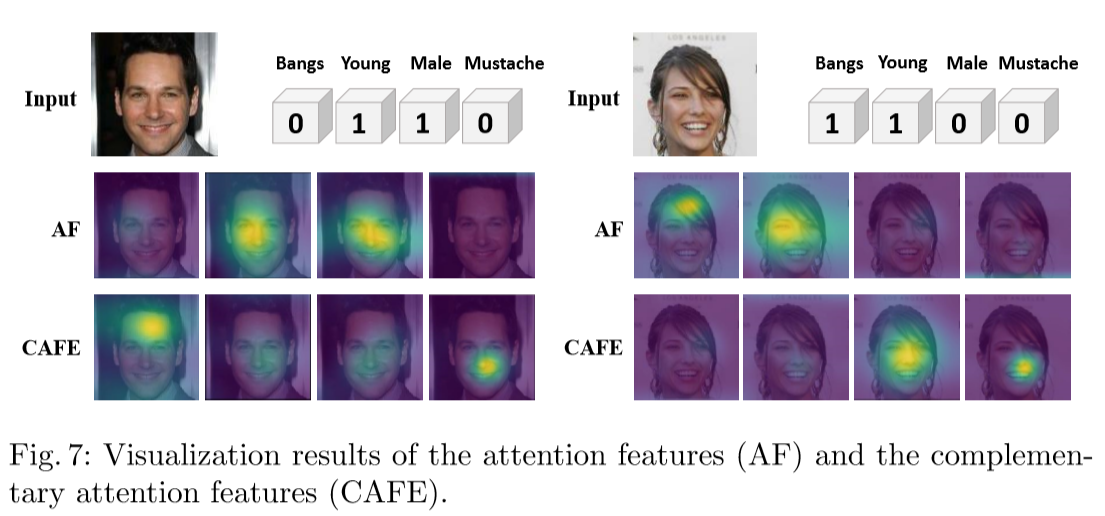

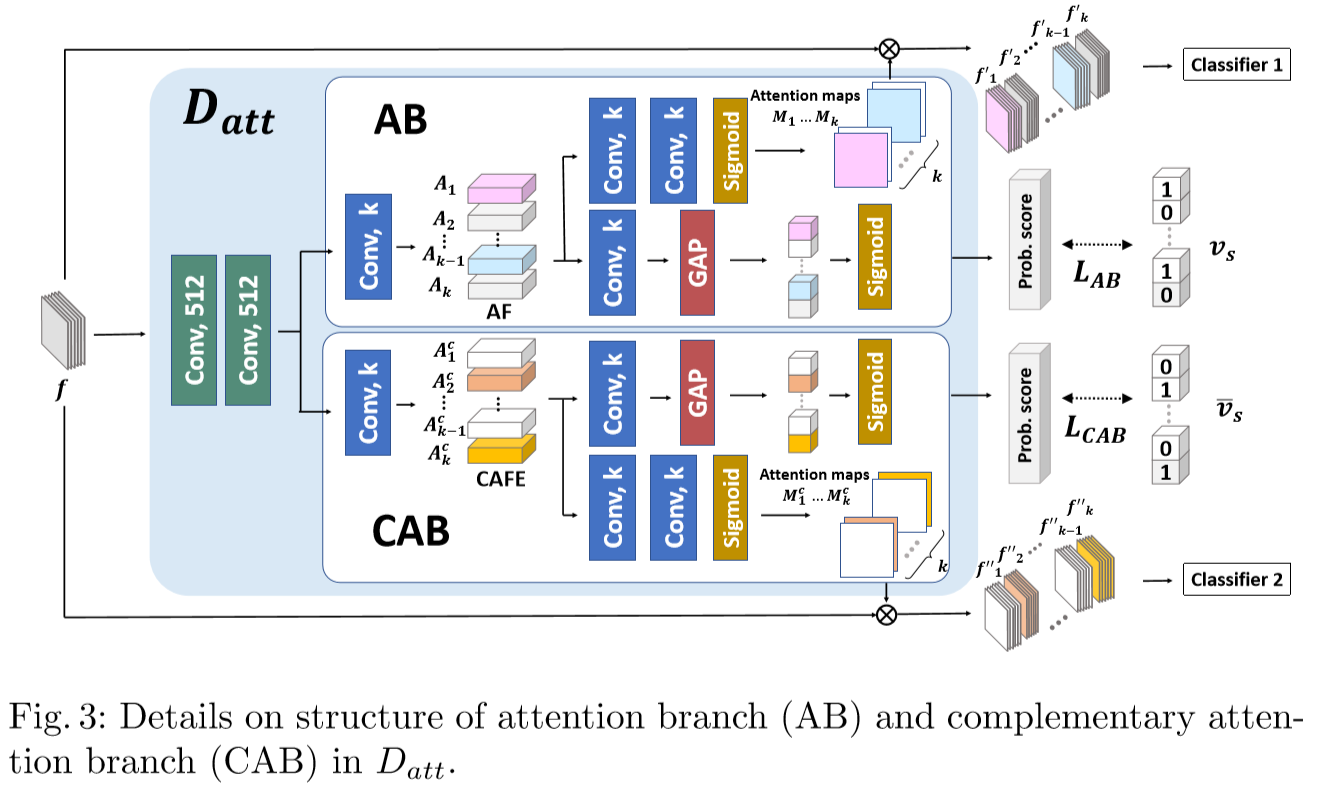

本文方法对中层特征f应用空间注意力机制,由一个注意分支(AB)和一个互补注意分支(CAB)构成,它们会生成k个注意力图(k表示属性的数量),AB的注意力图表示输入图像中存在的重要属性区域,而CAB的注意力图表示不存在的临时属性区域

AB:中层特征f经过卷积层生成一个h*w*k的注意力特征(AF),k对应着属性数,一方面经过1*1*k的卷积层和sigmoid层得到,另一方面通过1*1*k的卷积层和GAP及sigmoid去得到每个属性的概率分数,这里跟做交叉熵损失

AB通过获得A,A表示输入图像中包含的属性的空间信息。但是A不包含图像中没有出现的属性信息,因为Ai是feature map A的第i个通道,如果第i个属性不在输入图像中,它就没有响应。这不会影响像ABN这样的分类模型,因为它只需要激活一个与输入图像中显示的正确属性相对应的通道。

然而,对于任意属性的编辑,即使输入的图像并不具有该属性,生成模型也希望能够找到相关的空间区域,因此,将现有的可视化解释方法直接应用于属性编辑模型的判别器存在一定的局限性。为了解决这一问题,本文提出了互补注意力的概念,通过整合互补注意分支(CAB)实现了算法中的这一思想。

CAB:提取互补注意特征(CAFE),用表示图像中不存在的属性的causative regions。网络跟思路类似于AB

通过AB和CAB,我们的模型提取了所有属性的注意特征图,因为和是互补的。换句话说,对于任何第i个属性,如果没有响应值,就有响应值,反之亦然

AB和CAB的输出两组注意图M和对属性的激活不同。换句话说,M是关于输入图像已有的属性,而是关于输入图像缺失的属性。经过注意机制后,将变换后的特征转发到中的两个多属性分类器中,分类器1和分类器2分别用和对图像的正确标签进行分类

Dadv用于区分真实图像x和伪图像y,通过对抗学习来保证输出的视觉真实感,这里使用WGAN-GP的损失函数:

生成器

生成器G以源图像x和目标属性标签为输入,进行x到y的变换,表示为。生成器的目标是在保持x身份的同时生成具有属性的图像y,生成器由编码器和两部分组成,即从给定的源图像x编码得到一个隐特征表示z,再由译码器译码隐特征表示z和差值属性向量生成一个y

所以生成器的分类损失为:

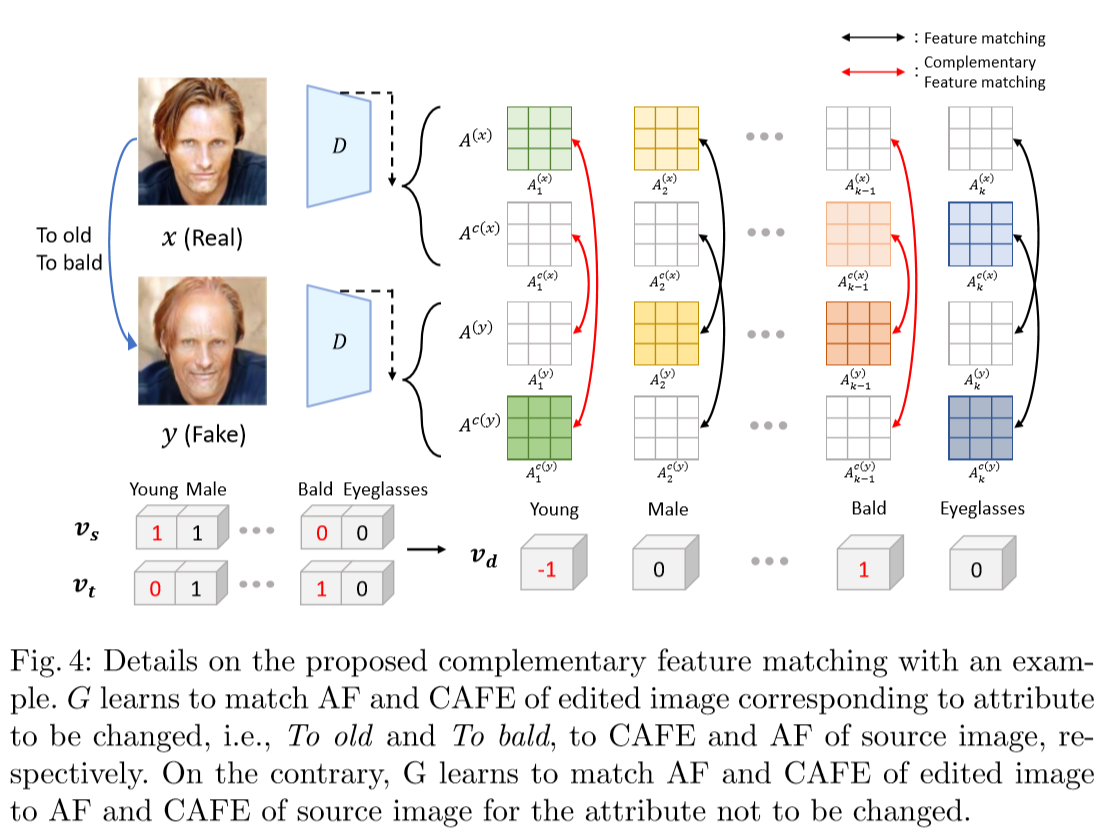

虽然判别器中的可以获得所有属性的空间信息,但有必要保证G能够改变给定目标属性的相关区域。源图像和编辑图像的注意特征图在属性改变时对应的注意特征图应该是不同的,而其余的注意特征图应该是相同的。即对于上图,不需要改变的属性(即黑色箭头),G学习将编辑后的图像的AF和CAFE与源图像的AF和CAFE进行匹配,对于需要编辑的属性(即红色箭头),G学习将编辑后的图像的AF和CAFE与源图像的CAFE和AF进行匹配,令和分别表示来自真实图像x和伪图像y的AF和CAFE集合,则互补匹配损失为:

生成器的对抗损失,采用WGAN-GP:

为了保持图像身份特征,生成器需要在差分属性向量为零时重构源图像,故像素级重建损失为:

总的损失函数

判别器:

生成器:

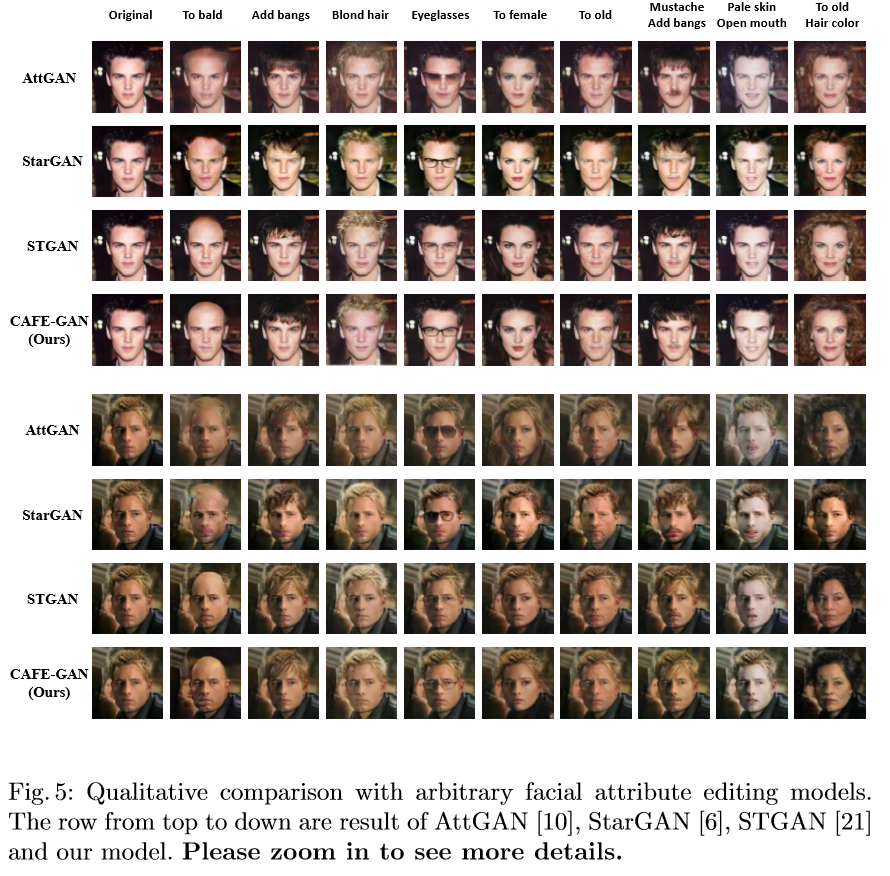

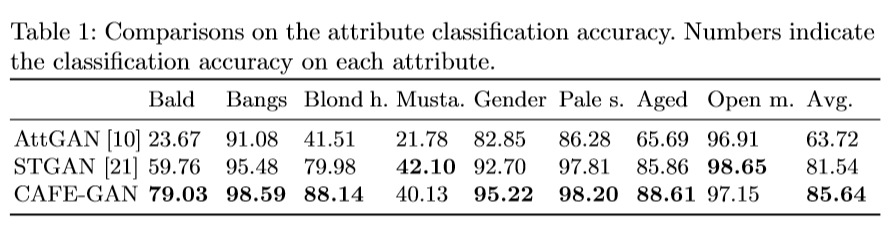

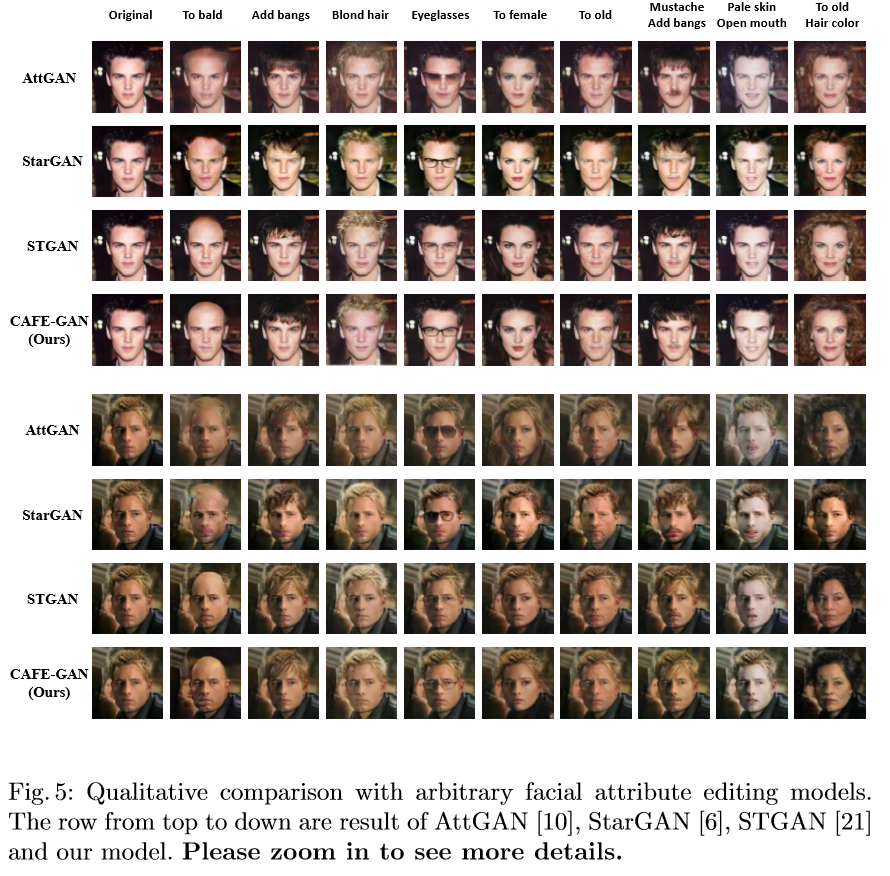

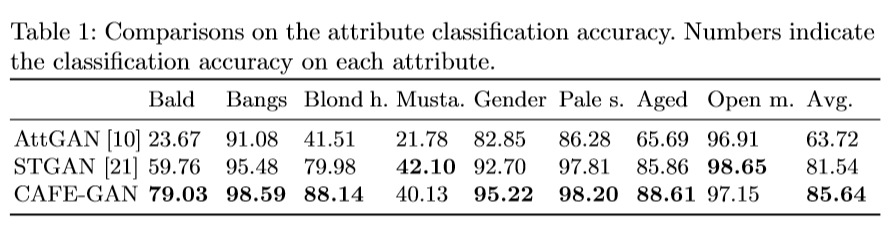

部分实验结果